Ciencia del primer cuartil

El otro día, mientras hacía una solicitud al Ministerio, recordé con pena la carta a Rajoy de Amaya Moro-Martín, una investigadora que dejaba definitivamente España para irse a trabajar al extranjero. En particular, mientras rellenaba ese famoso Curriculum Vitae Normalizado, recordaba esta frase:

Le envío las 700 páginas de certificados y documentos que tenía preparados para el día en que se convocara una plaza con mi perfil, algo que nunca ocurrió.

Porque, y esto es algo que la gente normalmente no sabe, los científicos somos evaluados constantemente y se nos exige certificar todos y cada uno de nuestros méritos a la hora de hacer una solicitud (aunque sean públicos). Vaya por delante que no estoy en contra de las evaluaciones. Es lógico que se nos evalúe para un puesto, igual que pasaría en cualquier otro ámbito. Lo que no es lógico es que se haga a través de un sistema retorcido e injusto, que está pensado para consumir nuestro tiempo e ilusiones, y para permitir cualquier excusa para rechazar candidatos.

Separación en cuartiles en una distribución normal. (Fuente: Wikipedia)

Y es que el otro día estuve toda una tarde buscando mis artículos publicados en revistas del primer cuartil. ¿Qué es eso? Pues veréis: para evaluar la «excelencia» en investigación se utilizan ciertos parámetros que miden, o pretenden medir, la productividad y el impacto de tu trabajo. Hay muchas formas de hacer eso. Por ejemplo, un indicador puede ser el número total de artículos publicados o el número de artículos por año. Otro es el número de artículos publicados en las revistas más citadas de su campo (las que están en el 25% más alto o primer cuartil), y eso es lo que yo tuve que revisar.

Evidentemente toda esta información es pública, y la FECYT ya paga por tener acceso a la Web of Science, donde tenemos un perfil de investigador que cualquiera puede consultar. En una era en la que todos los datos son accesibles con tres clics, es ridículo que se nos oblige a hacer este informe de estadísticas en el curriculum. Porque además estas estadísticas valen sólo para hoy. El próximo año los cuartiles cambiarán en función del llamado factor de impacto de las revistas¹. Es decir, que lo que hoy puede ser un artículo «malo», mañana puede ser un gran artículo. Y por supuesto, el factor de impacto depende del área de estudio: NO SIRVE como indicador de calidad.

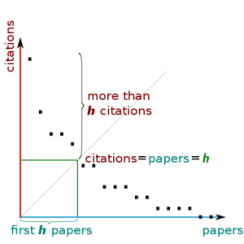

Aunque lo que se lleva ahora, más que el cuartil, es el índice H, que es un indicador propuesto por el físico Jorge E. Hirsch (¡en 2005!) basado en las citas recibidas. Las citas han sido siempre una forma de ver la importancia de un trabajo. Un artículo muy citado suele indicar que el trabajo es muy bueno o que supone un gran avance. Aunque hay excepciones (por ejemplo, a veces un trabajo es muy citado por ser incorrecto, o por ser un artículo de revisión del tema), en general las citas funcionan tan bien que Google asumió este sistema para ordenar las búsquedas en internet (el patentado PageRank). Así, una página muy enlazada se identifica como una página muy importante, y a su vez los enlaces que salen de esa página también tienen más peso porque vienen de una fuente considerada importante².

Sistema PageRank de Google, inspirado en el peso de las citas científicas. (Fuente: Wikipedia)

El índice H intenta medir al mismo tiempo el número de artículos (productividad) y el número de citas (relevancia). Por ejemplo, el otro día pasé a tener un H=10, lo que significa que tengo 10 artículos con 10 o más citas. Por supuesto, tengo más de 10 artículos publicados en total, pero el índice H dice que sólo 10 de todos son relevantes. Para tener un H=11 necesitaría tener 11 artículos con 11 o más citas, por lo que ya podéis ver que este índice crece muy despacio, y cada vez es más difícil tener un H alto. Me gustaría añadir aquí que algunos de los que yo considero mis mejores artículos no están entre los más citados, sencillamente porque tratan temas que son minoritarios o que no son un tema de moda.

Se sabe que el índice H, por varias razones, no es un parámetro preciso para evaluar investigadores individualmente. Para empezar depende de la antigüedad: un investigador más joven tendrá normalmente un índice H más bajo. También puede haber personas con un H idéntico pero con una gran diferencia en el número total de citas. Y además, de nuevo el número de citas suele depender del área o de la revista donde se publica, por lo que es injusto comparar el H de personas con distintas áreas de trabajo. Hay más consideraciones a tener en cuenta, y en el blog de Francisco R. Villatoro podéis encontrar muchos detalles sobre esto. Pero en resumen: el índice H puede ser un buen indicador (mide la cola de la distribución de artículos más citados, donde se encuentra la excelencia), pero no es un buen criterio.

Evolución de mis citas recibidas según la Web of Science.

El riesgo de evaluar a los científicos con parámetros bibliométricos es que al final acabas por conseguir lo que mides. Es un conocido sesgo en Ciencia. Si pides que la gente publique en revistas del primer cuartil la gente acabará por publicar sólo en revistas del primer cuartil. ¿Eso hace mejor la ciencia publicada? NO. De la misma forma ya empieza a haber casos de ingeniería del índice H, es decir, que hay autores que se citan entre ellos para subir su H. Es un sistema perverso, que no ayuda nada a que mejore la ciencia.

Y es que, en temas de calidad en investigación recuerdo siempre una clarificadora charla de Alonso Rodríguez Navarro (catedrático de Microbiología en la Universidad Politécnica de Madrid), de la que ahora recupero aquí una idea esencial:

La mayor parte de la ciencia que se publica es normal, pero la ciencia revolucionaria se apoya en esa ciencia normal.

Resulta, sin embargo, que no hay correlación entre el volumen de la ciencia “normal” y el de los descubrimientos importantes, y que los índices bibliométricos típicos dicen muy poco de la excelencia³. Así que, si quieren juzgar nuestro trabajo usen el indicador que les guste más: el primer cuartil, el índice H, el índice K, el número de contactos de ResearchGate…, pero por favor no nos hagan perder más tiempo de nuestro día en el laboratorio. Queremos investigar.

@DayInLab

¹ El factor de impacto de una revista es el número de citas dividido por el número de artículos publicados en ella.

² El sistema original de Google ha cambiado desde su origen, y ahora la jerarquía es también temporal o incluso condicionada al pago. Por ejemplo, cuando buscas el nombre de alguien famoso es probable que Google te saque primero alguna noticia reciente sobre él.

³ Puestos a jugar, como se especula en el artículo La universidad española y el ‘índice h’, ¿por qué no calcular el índice H de una institución o de un país? Por ejemplo, la Universidad Autónoma de Madrid tiene un H=101 en la última década 2005-2015, mientras que el Massachusetts Institute of Technology (MIT) tiene un H=147 únicamente en 5 años (2010-2015).

No obstante, para comparar bien la excelencia de la ciencia de un país los indicadores importantes no se basan en el índice H sino en:

- Número de premios Nobel.

- Número de patentes triádicas (en Europa, Japón y Estados Unidos).

- Número de trabajos científicos en el 1% más citado.

Y aquí salimos bastante mal parados, porque como país sólo tenemos 2 premios Nobel en Ciencia, mientras que el MIT, una única institución, tiene 85.

«…es ridículo que se nos oblige a hacer este informe de estadísticas en el curriculum.» Yo que tú me preocuparía más por tener tu curriculum completo y actualizado, luego le dan la plaza a otro con más artículos y citas y vienen los lloros…

[…] Y aunque vivimos en un sistema de escalas y métricas en el que se clasifica a la gente por índices y cuartiles, y del que los profesores somos cómplices, como ya te dije una vez: nunca dejes que nadie te diga […]

[…] os he contado en alguna ocasión que los científicos somos evaluados continuamente por nuestra producción. En teoría eso sirve para decidir nuestro nivel y nuestra calidad como investigadores, y el […]

[…] Ciencia del primer cuartil [Sobre lo ridíciulo de la carrera investigadora (a veces).] […]

[…] perversiones que existen en el mundo real de la ciencia, donde nos juzgan por citas, índice H, cuartiles y factores de impacto, nos abocan a un sistema en el que sólo unos pocos elegidos pueden […]

[…] vi claro. No intenté persuadirle. Sabía que sería inútil. Otra vez la estúpida ciencia del primer cuartil. ¿Hasta dónde vamos a […]

[…] a Kuhn (en su famoso ensayo sobre las revoluciones científicas) sabe que la mayor parte de la ciencia es «normal», no […]